Wewnętrzne duplikaty stron to jeden z częstych problemów, z którymi borykają się właściciele stron internetowych. Taka sytuacja ma miejsce, gdy różne strony internetowe mają różne adresy URL, ale zawierają identyczną lub prawie identyczną treść. Obecność duplikatów negatywnie wpływa na pozycjonowanie strony w wyszukiwarkach, obniża jej widoczność i utrudnia osiągnięcie wysokich pozycji w wynikach wyszukiwania. Przyjrzyjmy się szczegółowo, skąd biorą się wewnętrzne duplikaty stron, jak je zidentyfikować i jakie są metody walki z nimi.

Główne przyczyny pojawiania się wewnętrznych duplikatów stron

Wewnętrzne duplikaty mogą mieć wiele przyczyn, w tym:

- Błędy w projektowaniu strony. Bardzo często duplikaty pojawiają się z powodu błędów w projektowaniu struktury strony. Na przykład produkty mogą być umieszczane w kilku kategoriach, posiadając identyczne opisy, co prowadzi do tworzenia kilku stron z identyczną treścią, ale różnymi adresami URL.

- Nieprawidłowa konfiguracja CMS. System zarządzania treścią (CMS) odgrywa kluczową rolę w zarządzaniu stroną. Jeśli CMS jest nieprawidłowo skonfigurowany, może automatycznie tworzyć duplikaty stron, szczególnie przy dodawaniu produktów do kilku kategorii lub tworzeniu stron tagów.

- Wtyczki i moduły. Niektóre wtyczki lub moduły mogą automatycznie tworzyć duplikaty stron, szczególnie jeśli odpowiadają za funkcje takie jak tworzenie tagów, paginacja lub dynamiczne generowanie treści. Wtyczki często rozszerzają możliwości CMS, ale przy niewłaściwej konfiguracji mogą prowadzić do pojawienia się dużej liczby duplikatów.

- Problemy z wersjonowaniem treści. Czasami ta sama strona może być dostępna pod różnymi wersjami adresów URL, co również prowadzi do tworzenia duplikatów. Na przykład strony mogą być wyświetlane z parametrami (np. ?page=1) lub bez nich.

- Sortowanie i filtrowanie produktów w sklepach internetowych. W sklepach internetowych problem duplikatów często wiąże się z używaniem parametrów do filtrowania lub sortowania produktów. Na przykład strony z filtrami według rozmiaru, koloru lub ceny mogą mieć różne adresy URL, ale praktycznie identyczną treść.

- Dynamiczne parametry URL. Używanie dynamicznych parametrów, takich jak sesje czy parametry śledzenia, również może prowadzić do powstawania duplikatów. Jest to szczególnie ważne dla stron, które generują adresy URL na podstawie danych o użytkownikach lub sesjach.

Rodzaje wewnętrznych duplikatów stron

Wewnętrzne duplikaty można podzielić na dwa typy:

- Pełne (jawne) duplikaty — strony, które mają różne adresy URL, ale identyczną treść.

- Częściowe (niejawne) duplikaty — strony, które różnią się nieznacznie (np. opiniami użytkowników lub zmienionymi parametrami produktów), ale zawierają podobną treść.

Przykłady pełnych duplikatów:

- Różne protokoły dostępu: http://site.com i https://site.com.

- Użycie lub brak prefiksu www: https://www.site.com i https://site.com.

- Różne wersje tej samej strony z powodu parametrów: https://site.com/catalog i https://site.com/catalog/?view=grid.

- Błędy w użyciu wielkich liter w adresie URL: https://site.com/About i https://site.com/about.

- Użycie parametrów śledzenia: https://site.com/page?utm_source=google i https://site.com/page.

Częściowe duplikaty mogą powstawać na przykład przy tworzeniu stron dla jednego produktu z różnymi kolorami lub rozmiarami, co prowadzi do prawie identycznej treści na każdej stronie.

Wpływ duplikatów na pozycjonowanie SEO

Wewnętrzne duplikaty stanowią poważny problem w kontekście SEO. Oto główne negatywne konsekwencje:

- Obniżenie pozycji w wynikach wyszukiwania. Gdy wyszukiwarka napotyka kilka stron z identyczną treścią, nie może określić, która z nich jest bardziej odpowiednia. W rezultacie wszystkie duplikaty rywalizują ze sobą, co zmniejsza szansę każdej z nich na zajęcie wysokiej pozycji.

- Kanibalizacja słów kluczowych. Obecność duplikatów prowadzi do kanibalizacji słów kluczowych, co oznacza, że kilka stron twojej witryny rywalizuje ze sobą o tę samą frazę, obniżając ogólną jakość SEO.

- Nieefektywne wykorzystanie budżetu crawlowania. Roboty wyszukiwarek mają ograniczony budżet na indeksowanie stron za jednym razem. Jeśli roboty tracą go na indeksowanie duplikatów, to zmniejsza się szansa, że ważne strony zostaną zaindeksowane na czas.

- Problemy z rankingiem. Niestabilne pozycje stron w wynikach wyszukiwania mogą wprowadzać w błąd właścicieli stron — duplikaty mogą na zmianę zajmować pozycje, co prowadzi do niestabilnej widoczności witryny.

- Pogorszenie doświadczeń użytkowników. Użytkownicy mogą natknąć się na identyczne strony, co prowadzi do zamieszania i pogarsza ich ogólne wrażenie z korzystania z witryny.

Metody wykrywania duplikatów stron

Aby skutecznie wykryć wewnętrzne duplikaty, można skorzystać z kilku metod:

- Ręczne wyszukiwanie. Jeśli masz małą witrynę, możesz ręcznie sprawdzić strony, korzystając z wyszukiwarek. Wpisz zapytanie typu

site:twója_domena inurl:fragmentURL, a wyszukiwarka wyświetli wszystkie strony, które odpowiadają temu URL. - Narzędzia do analizy witryny. Użycie specjalistycznego oprogramowania pozwoli zaoszczędzić czas i zwiększyć dokładność analizy. Oto niektóre popularne narzędzia:

- Netpeak Spider — pozwala na pełny audyt strony i wykrycie wszystkich wewnętrznych duplikatów.

- Screaming Frog SEO Spider — skuteczny skaner, który wykrywa duplikaty, niedziałające linki i inne problemy SEO.

- Xenu’s Link Sleuth — darmowe narzędzie do analizy witryny, które wykrywa zarówno duplikaty stron, jak i linki prowadzące do nieistniejących stron.

- Siteliner — narzędzie online, które analizuje stronę i określa obecność zduplikowanych treści.

- Sprawdzenie w Yandex.Webmaster lub Google Search Console. Narzędzia te pozwalają przeglądać zaindeksowane strony i identyfikować problemy z duplikatami.

- Ahrefs i SEMrush. Te narzędzia mogą pomóc w identyfikacji stron o niskiej unikalności treści oraz w analizie duplikatów.

Jak pozbyć się wewnętrznych duplikatów stron

Istnieje kilka sposobów na pozbycie się duplikatów. Ważne jest, aby wybrać odpowiednią metodę w zależności od przyczyny ich powstawania:

- 301 Redirect (przekierowanie). Jedna z najbardziej niezawodnych metod — skonfigurować przekierowanie 301 z duplikatów na oryginalną stronę. Dzięki temu można przenieść wartość z duplikowanej strony na główną i wyeliminować problem konkurencji między adresami URL.

- Atrybut

rel=canonical. Tag kanoniczny pozwala wskazać wyszukiwarkom, która strona jest główną wersją danej treści. W ten sposób, nawet jeśli istnieje kilka wersji strony, wyszukiwarki będą traktować tylko jedną z nich jako właściwą. - Użycie metatagów do blokowania indeksacji. Można użyć pliku

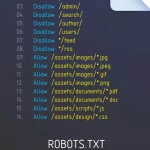

robots.txt, aby zablokować dostęp do niepotrzebnych stron. Na przykład strony z parametrami lub sesjami można zablokować dla indeksowania za pomocąDisallow.Przykład plikurobots.txtdo blokowania duplikatów stron:

User-agent: *

Disallow: /catalog/?view=grid

Disallow: /*?sort=

Disallow: /search?*- W tym przykładzie blokowane są strony z parametrami sortowania i wyszukiwania, aby zapobiec ich indeksacji i w konsekwencji powstawaniu duplikatów.Użycie pliku

robots.txtpomaga uniknąć indeksacji stron, które nie mają wartości dla wyszukiwarek, takich jak strony z parametrami, sortowaniami czy strony generowane sesyjnie. Warto jednak zrozumieć, że blokada wrobots.txtjedynie uniemożliwia indeksację, ale nie usuwa już zaindeksowanych duplikatów. - Prawidłowa konfiguracja CMS i wtyczek. Należy zwrócić szczególną uwagę na wybór i konfigurację wtyczek, aby wyeliminować automatyczne tworzenie duplikatów. Warto również skonfigurować strukturę adresów URL w sposób, który wyklucza powtórzenia.

- Usuwanie statycznych duplikatów. Jeśli duplikaty mają charakter statyczny i nie są już potrzebne, można je po prostu usunąć, aby zmniejszyć obciążenie robotów wyszukiwarek i poprawić indeksację strony.

- System URL przyjazny użytkownikowi (CNC). Używaj adresów URL przyjaznych SEO, aby uniknąć generowania niezrozumiałych i powtarzających się adresów. Optymalizowane i zrozumiałe linki ułatwiają zarządzanie stroną i zmniejszają prawdopodobieństwo powstawania duplikatów.

- Konfiguracja filtrowania i paginacji. W przypadku sklepów internetowych ważne jest prawidłowe skonfigurowanie parametrów filtrowania i paginacji, aby uniknąć tworzenia duplikatów. Używaj atrybutów

rel=nextirel=prev, aby prawidłowo indeksować strony z paginacją. - Blokowanie parametrów w Google Search Console. Google Search Console umożliwia blokowanie indeksacji stron z określonymi parametrami URL, aby zapobiec powstawaniu duplikatów.

Przykład skutecznego rozwiązania problemu z duplikatami

Rozważmy przykład sklepu internetowego, który napotkał problem duplikatów z powodu wielu produktów prezentowanych w kilku kategoriach. Rozwiązaniem było:

- Użycie przekierowania 301 do przekierowania wszystkich duplikatów na główną stronę produktu.

- Dodanie tagu kanonicznego, aby wyraźnie wskazać, która strona jest główną.

- Konfiguracja CMS do zarządzania produktami w taki sposób, aby wyeliminować automatyczne tworzenie duplikatów.

- Regularne kontrole za pomocą Netpeak Spider i Google Search Console w celu szybkiego wykrywania nowych duplikatów.

- Optymalizacja struktury adresów URL i konfiguracja filtrowania produktów, aby zminimalizować liczbę parametrów prowadzących do duplikatów.

Rezultatem tych działań było podwyższenie pozycji strony w wynikach wyszukiwania, zmniejszenie kanibalizacji słów kluczowych i poprawa ogólnej jakości indeksacji.

Przykład skryptu w Pythonie do wyszukiwania duplikatów stron

Poniższy skrypt w Pythonie pomoże automatycznie znajdować duplikaty stron na podstawie treści. Skanuje on stronę, zbiera zawartość każdej strony i porównuje ją z innymi stronami.

import requests

from bs4 import BeautifulSoup

from hashlib import md5

from urllib.parse import urljoin

class DuplicatePageFinder:

def __init__(self, base_url):

self.base_url = base_url

self.visited_urls = set()

self.page_hashes = {}

def get_page_content(self, url):

try:

response = requests.get(url)

if response.status_code == 200:

return response.text

return None

except requests.RequestException as e:

print(f"Error fetching {url}: {e}")

return None

def hash_content(self, content):

return md5(content.encode('utf-8')).hexdigest()

def find_duplicates(self, url):

if url in self.visited_urls:

return

self.visited_urls.add(url)

content = self.get_page_content(url)

if content is None:

return

content_hash = self.hash_content(content)

if content_hash in self.page_hashes:

print(f"Duplicate found: {url} and {self.page_hashes[content_hash]}")

else:

self.page_hashes[content_hash] = url

soup = BeautifulSoup(content, 'html.parser')

for link in soup.find_all('a', href=True):

next_url = urljoin(self.base_url, link['href'])

if next_url.startswith(self.base_url):

self.find_duplicates(next_url)

if __name__ == "__main__":

base_url = "https://example.com"

finder = DuplicatePageFinder(base_url)

finder.find_duplicates(base_url)Ten skrypt rekurencyjnie przeszukuje strony twojej witryny, oblicza hash zawartości każdej strony i porównuje je. Jeśli zostaną wykryte strony o identycznym hash’u, są one uważane za duplikaty, a informacje o nich są wyświetlane na ekranie.

Regularny audyt — klucz do sukcesu

Aby utrzymać stabilne pozycje strony, ważne jest regularne przeprowadzanie audytu pod kątem duplikatów. Sprawdzanie strony powinno być częścią twojej strategii SEO. Nawet po usunięciu wszystkich duplikatów, ich ponowne pojawienie się jest możliwe — szczególnie w przypadku dodania nowej treści, modułów lub zmiany struktury adresów URL.

Użycie takich narzędzi jak Netpeak Spider, Screaming Frog i Google Search Console pozwoli ci być pewnym braku problemów z duplikatami i reagować na ewentualne zmiany na czas.

Ponadto, ważne jest śledzenie zmian w algorytmach wyszukiwarek, ponieważ mogą one wpłynąć na sposób przetwarzania duplikatów. Regularne aktualizowanie wiedzy i stosowanie aktualnych praktyk pomoże uniknąć problemów w przyszłości.

Podsumowanie

Wewnętrzne duplikaty stron to poważny problem, który uniemożliwia stronie zajęcie wysokich pozycji w wyszukiwarkach. Obniżenie widoczności, kanibalizacja słów kluczowych, problemy z rankingiem — to wszystko są konsekwencje obecności duplikatów. Korzystanie z odpowiednich narzędzi do ich wykrywania oraz metod ich usuwania (przekierowania 301, tagi kanoniczne, blokowanie niepotrzebnych stron) to ważne kroki w kierunku sukcesu twojej witryny. Regularny audyt i ciągłe śledzenie zmian pomogą utrzymać stronę w dobrej kondycji i zapewnić jej wysokie pozycje w wynikach wyszukiwania.

Nie zapominaj także o znaczeniu optymalizacji doświadczeń użytkowników. Jasna i przemyślana struktura strony bez duplikatów nie tylko przyczynia się do poprawy SEO, ale również sprawia, że twoja witryna jest bardziej przyjazna dla użytkowników, co w efekcie prowadzi do zwiększenia konwersji i wzrostu biznesu.